许多年以后,学了矩阵乘法,嘉豪将会回想起,他小学老师警告他乘法不能在所有情况下交换的那个下午。

——《百年数独》

引言:重塑“乘法”之意义

“乘法交换律”,这是一个如同“1+1=2”一样,自我们首次踏入数学殿堂便被奉为圭臬的公理。它如同一块坚实的基石,支撑着我们整个算术与初等代数的大厦。对于那个小学下午的嘉豪来说,3 x 5 与 5 x 3 得到相同的结果是天经地义的,它反映了一种深刻的对称性与秩序,我们对世界的朴素认知也由此建立。然而,数学的宏伟版图远不止于我们最初瞥见的田园风光。在它的深邃腹地,存在着截然不同的法则与大陆,而矩阵乘法,正是我们通往这片新世界的第一个,也是最具颠覆性的关口。

当嘉豪最终在高等数学中与矩阵乘法相遇时,他所面临的冲击是根本性的。他的老师会告诉他,一般情况下,矩阵 A 乘以矩阵 B,并不等于矩阵 B 乘以矩阵 A。这不仅仅是一个令人不安的例外,而是一种常态。AB ≠ BA 这个简单的不等式,是对我们关于“乘法”这个概念最原始直觉的悍然挑战。一个自然而然的问题便会涌上心头:为什么我们还要称其为“乘法”?这种看似怪异、不符合直觉的运算规则,究竟从何而来,它又揭示了怎样一个更深层次的数学或物理实在?

本文的使命,正是要系统而彻底地回答这些问题。我们将不仅仅学习如何计算矩阵乘法,更将深入探索它为何如此定义。我们将一同踏上一条从具体到抽象、从代数到几何、从理论到实践的旅途。我们将回溯到19世纪,见证它在线性方程组求解中的诞生;我们将深入其几何灵魂,理解矩阵作为空间变换的本质;我们还将解剖其在现代计算机中的实现,并一窥它如何成为从计算机图形学到人工智能等尖端科技的绝对基石。

读完本文,你将获得的不仅仅是一个计算工具。你将获得一种全新的“视觉”,一种看待和理解线性系统、数据关系和空间变换的数学直觉。那个曾让嘉豪困惑的下午,将成为你认知升级的辉煌起点。你将深刻理解,乘法之所以不能交换,恰恰因为它所描述的世界——一个由有序操作和变换构成的世界——其本身就是非交换的。这并非数学的缺陷,而是其表达能力的伟大胜利。

1. 历史的回响:作为线性方程组优雅解的矩阵

在深入探讨那些令人眼花缭乱的几何变换之前,我们必须先回到矩阵乘法最原始的诞生地——线性代数的核心问题:求解线性方程组。这不仅是历史的真实路径,也是理解其运算规则为何如此“怪异”的最坚实的基础。

想象一下19世纪的数学家,例如高斯或柯西,他们面对的是一类反复出现且极为棘手的问题。比如下面这个简单的二元一次方程组:

$$ \begin{cases} 2x + 3y = 8 \\ 5x – 1y = 3 \end{cases} $$

我们可以通过代入消元法等手段求解。但当变量和方程的数量增加到三个、四个,乃至成百上千个时(例如在天体力学轨道计算或大地测量中),这种手动的、过程化的计算方式会变得异常繁琐且极易出错。数学家们迫切需要一种更简洁、更结构化的表示法和一套标准化的操作规则。

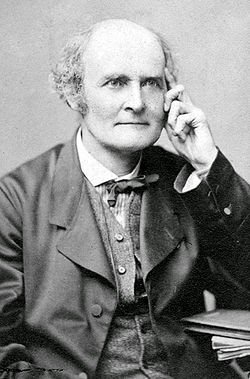

英国数学家阿瑟·凯莱(Arthur Cayley)在19世纪中叶的开创性工作,正是为了应对这一挑战。他引入了“矩阵”和“向量”的概念,将上述方程组“打包”成一种极为优雅的形式。

1821 · 08 · 16 – 1895 · 01 · 26

首先,我们将所有系数抽离出来,形成一个我们称之为系数矩阵 A 的矩形数阵:

$$ A = \begin{bmatrix} 2 & 3 \\ 5 & -1 \end{bmatrix} $$

然后,我们将未知数 x 和 y 组织成一个列向量 x(向量可以看作是只有一列的特殊矩阵):

$$ \mathbf{x} = \begin{bmatrix} x \\ y \end{bmatrix} $$

最后,我们将方程右侧的常数也组织成一个列向量 b:

$$ \mathbf{b} = \begin{bmatrix} 8 \\ 3 \end{bmatrix} $$

现在,整个方程组被简洁地表达为:

$$ A\mathbf{x} = \mathbf{b} $$

这个表达式看起来干净利落,但它目前还只是一个符号上的约定。它的威力在于,我们必须去定义一种矩阵与向量之间的“乘法”,使得 Ax 的计算结果恰好能还原出原始方程组的左侧。让我们看看需要发生什么:

$$ \begin{bmatrix} 2 & 3 \\ 5 & -1 \end{bmatrix} \begin{bmatrix} x \\ y \end{bmatrix} = \begin{bmatrix} 2x + 3y \\ 5x – 1y \end{bmatrix} $$

为了让这个等式成立,矩阵与向量的乘法必须遵循一个特定的模式:结果向量的第一个元素(2x + 3y),是由矩阵 A 的第一行 [2, 3] 与向量 x 的列 [x, y] 的对应元素相乘再相加得到的。同样,结果向量的第二个元素(5x - 1y),是由矩阵 A 的第二行 [5, -1] 与向量 x 的列对应相乘再相加得到的。

这个“行乘以列”的规则,并非凭空捏造,而是为了保持 Ax=b 这一记法与原始方程组在逻辑上完全等价所必然导出的结果。它是需求驱动的产物,而非随意的发明。

深度求索:从变量替换到矩阵乘法

现在,让我们把情况变得更复杂一些,这也是揭示矩阵与矩阵相乘定义的关键一步。假设我们有一组变量 x, y,它们由另一组变量 u, v 线性表示:

$$ \begin{cases} x = 7u + 1v \\ y = 4u + 9v \end{cases} $$

同时,我们还有第三组变量 z1, z2,它们由 x, y 线性表示:

$$ \begin{cases} z_1 = 2x + 3y \\ z_2 = 5x – 1y \end{cases} $$

一个自然的问题是:z1, z2 如何由 u, v 直接表示?我们可以进行纯粹的代数替换:

将 x 和 y 的表达式代入到 z1 和 z2 的表达式中:

z1 = 2(7u + 1v) + 3(4u + 9v) = (2*7 + 3*4)u + (2*1 + 3*9)v = 26u + 29vz2 = 5(7u + 1v) - 1(4u + 9v) = (5*7 - 1*4)u + (5*1 - 1*9)v = 31u - 4v

现在,让我们用矩阵的语言来重述整个过程。

z 与 x,y 的关系可以写成 z = Ax:

$$ \begin{bmatrix} z_1 \\ z_2 \end{bmatrix} = \begin{bmatrix} 2 & 3 \\ 5 & -1 \end{bmatrix} \begin{bmatrix} x \\ y \end{bmatrix} $$

其中 A 是我们熟悉的那个矩阵。

x,y 与 u,v 的关系可以写成 x = Bu:

$$ \begin{bmatrix} x \\ y \end{bmatrix} = \begin{bmatrix} 7 & 1 \\ 4 & 9 \end{bmatrix} \begin{bmatrix} u \\ v \end{bmatrix} $$

其中 B 是新的系数矩阵。

我们想要找到一个矩阵 C,使得 z = Cu,即直接建立 z 和 u 的关系。从代数上看,我们有 z = A(Bu) = (AB)u,所以 C 应该就是 A 和 B 的“乘积”。

让我们看看 C 应该是什么样子。根据我们刚刚费力计算出的结果:

$$ \begin{cases} z_1 = 26u + 29v \\ z_2 = 31u – 4v \end{cases} \Rightarrow C = \begin{bmatrix} 26 & 29 \\ 31 & -4 \end{bmatrix} $$

现在,我们面临着定义矩阵乘法的“审判时刻”。我们必须定义一种 A 和 B 之间的乘法运算,使得 AB 的结果恰好是 C。

$$ A \times B = \begin{bmatrix} 2 & 3 \\ 5 & -1 \end{bmatrix} \times \begin{bmatrix} 7 & 1 \\ 4 & 9 \end{bmatrix} = \begin{bmatrix} ? & ? \\ ? & ? \end{bmatrix} $$

让我们聚焦于结果 C 的左上角元素 26。回顾我们的代数推导,26 来自于 (2*7 + 3*4)。请注意看这些数字的来源:[2, 3] 正是矩阵 A 的第一行,而 [7, 4] 正是矩阵 B 的第一列!

再看 C 的右上角元素 29。它来自于 (2*1 + 3*9)。[2, 3] 是 A 的第一行,而 [1, 9] 是 B 的第二列。

规律已经昭然若揭!结果矩阵 C 中第 i 行、第 j 列的元素 C[i, j],正是由矩阵 A 的第 i 行与矩阵 B 的第 j 列,进行对应元素相乘再求和(这个过程也被称为点积或内积)得到的。

这,就是矩阵乘法那条著名但常常显得有些神秘的“行乘以列”规则的代数起源。它不是一个武断的规定,而是为了使“变量的线性组合的线性组合,其系数矩阵是原系数矩阵的乘积”这一美妙的性质得以成立,所必须采取的唯一合理的定义。它完美地将繁琐的代数替换操作,封装进了一套干净、统一的矩阵运算框架中。

2. 几何的直觉:作为空间变换指令的矩阵

如果说上一节我们从代数层面建立了矩阵乘法规则的合法性,那么这一节,我们将为它注入灵魂。我们将揭示,矩阵远不止是系数的容器,它本质上是线性变换的几何化身。而矩阵乘法,正是变换的复合。

想象一个二维平面,上面布满了无数的向量。一个变换就是一个函数,它接收一个向量作为输入,然后输出一个变换后的新向量。所谓线性变换,是一种特殊的、表现良好的变换,它保持了网格线的平行和等距。用更严格的数学语言来说,一个变换 T是线性的,如果它满足以下两个条件:

T(v + w) = T(v) + T(w)(可加性:两个向量相加后的变换,等于它们各自变换后再相加)T(c*v) = c*T(v)(齐次性:一个向量伸缩c倍后的变换,等于它变换后再伸缩c倍)

现在,让我们思考一个关键问题:如何用数字来描述一个二维平面上的线性变换?答案出奇的简单:我们只需要追踪这个变换对基向量做了什么。

在标准的二维笛卡尔坐标系中,我们的基向量是:î = [1, 0] (沿x轴的单位向量)ĵ = [0, 1] (沿y轴的单位向量)

任何一个向量 v = [x, y] 都可以表示为这两个基向量的线性组合:v = x*î + y*ĵ。

由于线性变换的性质,我们可以推导出变换后的向量 T(v) 是什么:T(v) = T(x*î + y*ĵ) = T(x*î) + T(y*ĵ) = x*T(î) + y*T(ĵ)

这个公式是理解矩阵几何意义的根基!它告诉我们:只要我们知道变换后的基向量 T(î) 和 T(ĵ) 在哪里,我们就能立刻确定任何一个向量 v=[x,y] 经过变换后的位置。

假设某个线性变换 L 把 î 变换到了 [a, c],把 ĵ 变换到了 [b, d]。

即:L(î) = [a, c],L(ĵ) = [b, d]。

那么,向量 v=[x,y] 变换后的结果 L(v) 就是:L(v) = x*[a, c] + y*[b, d] = [xa + yb, xc + yd]

现在,让我们构造一个矩阵 M,它的第一列就是变换后的 î,第二列就是变换后的 ĵ:

$$ M = \begin{bmatrix} a & b \\ c & d \end{bmatrix} $$

然后,我们来计算矩阵 M 与向量 v 的乘积 Mv (使用我们在第一节中推导出的行-列规则):

$$ Mv = \begin{bmatrix} a & b \\ c & d \end{bmatrix} \begin{bmatrix} x \\ y \end{bmatrix} = \begin{bmatrix} ax + by \\ cx + dy \end{bmatrix} $$

看到了吗?Mv 的计算结果与我们从几何上推导出的 L(v) 完全一样!

这是一个极其重要的观察:一个2×2矩阵,就是对二维空间进行一次线性变换的指令。它的列,明确地告诉我们,原来的基向量 î 和 ĵ 会被变换到哪里去。而矩阵乘以一个向量,就是在几何意义上将那个变换施加于该向量。

例如:

- 旋转矩阵:逆时针旋转90度的变换,会把

î=[1,0]变到[0,1],把ĵ=[0,1]变到[-1,0]。所以,这个变换对应的矩阵就是[[0, -1], [1, 0]]。 - 剪切矩阵:一个水平剪切变换,保持

î不变,但把ĵ=[0,1]推到[1,1]。这个变换的矩阵就是[[1, 1], [0, 1]]。

几何直觉下的矩阵乘法:变换的接续上演

有了这个强大的几何直觉,我们终于可以从一个全新的、更根本的视角来理解矩阵乘法的真谛,并一举攻克“非交换性”的谜题。

如果单个矩阵代表一次变换,那么两个矩阵相乘 A × B 代表什么?

答案是:代表两个变换的连续施加。 更具体地说,AB所代表的复合变换,是“先施加变换 B,然后施加变换 A”。(注意这个顺序,这在数学上称为函数复合,g(f(x)) 写作 (g∘f)(x),f 先作用)。

假设我们有一个向量 v,我们想对它先做 B 变换,再做 A 变换。

- 经过

B变换,v变成了Bv。我们称这个新向量为v'。 - 接着,我们对

v'再进行A变换,结果是A(v'),也就是A(Bv)。 - 根据矩阵乘法的结合律,

A(Bv)等于(AB)v。

这说明,矩阵乘积 AB 这个单一的矩阵,它所代表的变换效果,与“先应用 B 变换,再应用 A 变换”的组合效果是完全一样的。AB 就是这个复合变换的“快捷方式”或“浓缩指令”。

非交换性的豁然开朗

现在,那个困扰嘉豪的问题——为什么 AB ≠ BA ——终于有了清晰、直观的几何解释。

ABv 意味着对v“先B,再A”。BAv 意味着对v“先A,再B”。

在空间变换的世界里,操作的顺序至关重要。

让我们来看一个经典的例子:

- 令

A为逆时针旋转90度的变换:A = [[0, -1], [1, 0]] - 令

B为水平剪切变换:B = [[1, 1], [0, 1]]

让我们看看 AB 和 BA 分别是什么:

1. 计算 AB (先剪切,再旋转)

$$ AB = \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} \begin{bmatrix} 1 & 1 \\ 0 & 1 \end{bmatrix} = \begin{bmatrix} (0 \cdot 1 + (-1) \cdot 0) & (0 \cdot 1 + (-1) \cdot 1) \\ (1 \cdot 1 + 0 \cdot 0) & (1 \cdot 1 + 0 \cdot 1) \end{bmatrix} = \begin{bmatrix} 0 & -1 \\ 1 & 1 \end{bmatrix} $$

几何上,先剪切再旋转,会把 î 变到 [0,1],把 ĵ 变到 [-1,1]。这正是 AB 矩阵的列!

2. 计算 BA (先旋转,再剪切)

$$ BA = \begin{bmatrix} 1 & 1 \\ 0 & 1 \end{bmatrix} \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} = \begin{bmatrix} (1 \cdot 0 + 1 \cdot 1) & (1 \cdot (-1) + 1 \cdot 0) \\ (0 \cdot 0 + 1 \cdot 1) & (0 \cdot (-1) + 1 \cdot 0) \end{bmatrix} = \begin{bmatrix} 1 & -1 \\ 1 & 0 \end{bmatrix} $$

几何上,先旋转再剪切,会把 î 变到 [1,1],把 ĵ 变到 [-1,0]。这正是 BA 矩阵的列!

显然,AB ≠ BA。因为“先穿袜子再穿鞋”和“先穿鞋再穿袜子”是截然不同的结果。矩阵乘法的不交换性,不是一个缺陷,而是它忠实地反映了我们生活的这个世界中,操作顺序这一基本现实。从冲泡咖啡到编程,从化学反应到量子力学的测量,顺序决定一切。矩阵乘法,为我们提供了描述这种有序、非交换世界的数学语言。

3. 性能与实现:计算机如何驯服这头巨兽

我们已经领略了矩阵乘法的理论优雅性,但要在现实世界中发挥其威力,我们必须面对一个残酷的工程现实:矩阵乘法是计算密集型的。理解计算机如何高效地执行这一操作,是连接理论与应用,尤其是理解现代高性能计算和人工智能硬件的关键。

朴素算法及其性能瓶颈

让我们回顾矩阵乘法 C = AB 的形式化定义,其中 A 是 m x n 矩阵, B 是 n x p 矩阵, C 是 m x p 矩阵:

$$C_{ij} = \sum_{k=1}^{n} A_{ik} B_{kj}$$

这个定义直接就可以翻译成一个三重嵌套循环的“朴素”算法:

for i from 0 to m-1:

for j from 0 to p-1:

sum = 0

for k from 0 to n-1:

sum += A[i][k] * B[k][j]

C[i][j] = sum

return C这个算法直观易懂,但在性能上却是灾难性的。对于两个 n x n 的方阵,三个循环的层数分别是 n, n, n。这意味着总的乘法和加法操作次数与 n 的三次方成正比。我们称其时间复杂度为 O(n³)。

n 较小时,这不成问题。但当 n 增大时,计算量会爆炸性增长。一个 1000 x 1000 的矩阵,就需要 1000³ = 10亿次乘法和 10亿次加法。在今天的AI模型中,动辄 4096x4096 或更大的矩阵运算司空见惯,O(n³) 的天花板实在太低了。

超越 O(n³):更快的理论算法

一个自然的问题是:我们能做得比 O(n³) 更好吗?

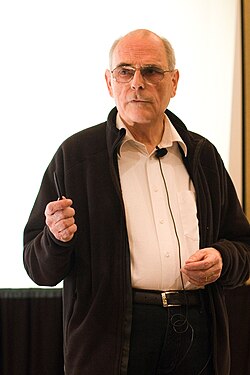

1969年,德国数学家 Volker Strassen 投下了一颗重磅炸弹。他发现,对于 2x2 矩阵乘法,可以通过一个巧妙的构造,用 7 次乘法 和 18 次加减法完成,而不是朴素算法所需的 8 次乘法和 4 次加法。

1936 · 04 · 29 – 至今

Strassen 算法的核心思想是分治法:将大矩阵递归地拆分成 2x2 的子矩阵块,然后用他的 7 乘法公式来计算块间的乘积。虽然加法次数增多了,但乘法是更昂贵的操作,且递归的威力使得整体复杂度得以降低。其最终的时间复杂度为 O(n^log₂(7)),约等于 O(n^2.807)。这在理论上是一个巨大的突破,证明了 O(n³) 并非不可逾越的铁壁。

在 Strassen 之后,一系列更复杂的算法在理论上将复杂度指数 ω 不断推向极限。目前理论上的最佳成绩 ω 已经非常接近 2。然而,这些理论算法的常数因子巨大,且实现复杂,在实践中往往只对极大尺寸的矩阵才有优势。

真实世界的优化:内存层次与并行计算

对于实际的计算机系统而言,O(n³) 的朴素算法还有一个更致命的问题:糟糕的内存访问模式。

现代CPU的速度远超内存。为了弥合差距,CPU内置了多级高速缓存(L1, L2, L3 缓存)。如果CPU需要的数据恰好在缓存中,速度极快;如果不在,就必须去慢速的内存中读取,带来巨大的延迟惩罚。

朴素算法的内存访问是“跳跃式”的。在计算 C[i][j] 时,它线性地扫描 A 的第 i 行,这是缓存友好的。但同时,它却要“垂直”地遍历 B 的一整列。在大多数编程语言的内存布局中(行主序),这意味着每访问 B 的一个元素,都要跳过一大段内存(一整行的长度),极易导致缓存未命中。

因此,现实世界中高性能矩阵乘法的核心,并非追求理论上最快的算法,而是最大化缓存利用率和并行化。

- 分块: 这是最核心、最有效的优化。其思想是将大矩阵

A和B切割成小的子矩阵(块),大小正好能装入CPU的某一级缓存。然后,算法不再是计算单个元素的点积,而是在这些小块之间进行“块乘法”。通过精心设计的循环顺序,可以确保一旦某几个块被加载到缓存中,它们会被反复利用,以完成所有相关的子计算,从而将昂贵的内存访问次数降到最低。 - 并行化:

- SIMD (Single Instruction, Multiple Data):现代CPU都支持SIMD指令集(如SSE, AVX)。这些指令允许一条CPU指令同时对多个数据(例如4个或8个浮点数)执行相同的操作(如乘法或加法)。矩阵乘法中的点积运算,天然适合用SIMD来加速。编译器和底层库会自动将内层循环“向量化”,以利用这种硬件能力。

- 多核并行: 矩阵乘法同样是“易于并行”的。结果矩阵

C的每一个元素C[i,j]的计算都是独立的。因此,可以轻易地将C的行或列的计算任务,分配给不同的CPU核心同时执行,实现接近线性的性能提升。

- GPU 加速: GPU 将并行计算的思想推向了极致。一个GPU拥有数千个小型的、相对简单的计算核心。它的架构天然就是为处理大规模、并行的浮点运算而设计的——这正是矩阵乘法的本质。通过CUDA(NVIDIA)或ROCm(AMD)等编程模型,可以将巨大的矩阵乘法任务分解成成千上万个线程,每个线程负责一小部分计算,在GPU的“计算海洋”中同时执行。这就是为什么GPU成为了深度学习革命的引擎——因为深度学习的核心,就是海量的矩阵乘法。

在实践中,没有人会手写用于生产环境的矩阵乘法循环。大家都会依赖高度优化的底层数学库,如 BLAS (Basic Linear Algebra Subprograms)。像 OpenBLAS, Intel MKL, Apple Accelerate 等库,它们的例程,是由顶级的编译器专家和硬件工程师,结合了分块、SIMD、多线程等所有优化手段,并针对特定CPU架构手写汇编调优的精华之作。当我们在 Python 中调用 NumPy 的 np.dot(A, B) 时,背后正是这些“性能猛兽”在无声地咆哮。

4. 多维度分析:超越计算的意义

矩阵乘法的影响力远远超出了纯数学和高性能计算的范畴。它是一种通用语言,被用来描述和操纵各个科学与工程领域的系统。

- 计算机图形学: 在3D游戏中你看到的每一个角色的移动、旋转和缩放,背后都是矩阵乘法在驱动。一个3D模型的每个顶点都可以用一个向量

(x, y, z)表示。一个变换矩阵(如旋转矩阵、缩放矩阵、平移矩阵)乘以这个顶点向量,就会得到顶点在变换后的新位置。将一系列变换组合起来,就对应着一系列变换矩阵的连乘。这样的流水线,是实时渲染的根基。 - 人工智能与机器学习: 矩阵乘法是神经网络的心跳。一个最基本的前馈神经网络层可以表示为

输出 = 激活函数(W * 输入 + b)。其中,输入是一个包含输入特征的向量,W是一个权重矩阵,b是偏置向量。W * 输入这个核心的矩阵-向量乘法,计算了所有输入特征的加权和。权重矩阵W的[i, j]元素,代表了第j个输入对第i个输出神经元的影响力。模型的“学习”过程,本质上就是通过反向传播算法,不断微调这个巨大的权重矩阵W的过程。像GPT-4这样的大语言模型,其内部进行的运算,绝大部分都可以归结为巨型矩阵之间的乘法。 - 量子计算: 在量子世界中,一个量子比特的状态可以用一个复数向量来描述。对量子比特进行的操作,即量子门,则由酉矩阵来表示。量子算法的执行过程,就是用代表量子门的矩阵,去乘以代表量子系统当前状态的向量,从而演化出新的状态。矩阵乘法是模拟和理解量子算法的数学基础。

- 图论: 一个图可以用邻接矩阵

A来表示。如果顶点i和j之间有边相连,则A[i,j] = 1,否则为0。矩阵乘法的威力在这里得到了惊人的体现:A² = A * A这个新矩阵,其元素(A²)[i,j]的值,恰好是从顶点i到顶点j长度为 2 的路径数量!更一般地,(A^k)[i,j]给出了从i到j长度为k的路径数量。 - 安全性分析: 虽然矩阵乘法本身不是安全协议,但对它的实现方式的攻击却是真实存在的。侧信道攻击,例如缓存计时攻击,可以被用来攻击加密算法的实现。如果一个加密算法的某个关键步骤依赖于与私钥相关的矩阵运算,攻击者可以通过精确测量矩阵乘法运算的时间或功耗变化,反推出与内存访问模式相关的信息,进而推断出CPU缓存中发生了什么,并可能从中泄露出关于私钥的信息。这要求在实现密码学库时,必须采用“恒定时间”的算法,消除数据相关性对执行时间的影响。

结语:从一到无穷,非交换世界的法则

我们从嘉豪那个充满困惑的下午出发,开启了这场漫长而深刻的旅程。现在,是时候回望我们的足迹,将所有的知识碎片拼合成一幅完整的图景了。

我们首先发现,矩阵乘法“行乘以列”的奇特规则,是为了求解线性方程组和描述线性组合的代换关系,所必然要求的代数结构。它将繁复的代数操作, 优雅地封装进了简洁的矩阵语言中。

接着,我们为这套代数规则注入了鲜活的几何灵魂。我们发现,矩阵的本质是空间线性变换的编码,而矩阵乘法 AB 的深刻含义,正是变换 B 与变换 A 的连续作用。AB ≠ BA 这个非交换性的核心谜题,也因此迎刃而解:它不是数学的瑕疵,而是对我们这个“顺序至关重要”的世界的忠实写照。先旋转再拉伸,与先拉伸再旋转,其结果本就不同。

然后,我们深入计算机的底层,看到了这个优雅理论在冰冷硅片上实现的残酷与智慧。我们理解了 O(n³) 的性能瓶颈,以及通过缓存优化、分块、并行计算等工程杰作来驯服这头计算巨兽的漫漫征途。我们明白了为何GPU能成为AI时代的“算力石油”,因为它就是一台为矩阵乘法而生的终极机器。

最后,我们环顾四周,发现矩阵乘法的触角无处不在,从构建虚拟的游戏世界,到赋予机器智能,再到描绘量子态的演化,它已成为现代科技文明的通用语法之一。

现在,我们可以回到嘉豪的问题了。小学老师教导的乘法交换律,是在数的王国——一个一维世界里的真理。在那里,操作是可逆的,顺序是无关紧要的。而矩阵乘法,则是高维空间中的法则。它所描述的变换,是结构性的、有方向的、不可随意交换的。学会矩阵乘法,是从一维的算术思维,跃升至多维的、系统的、变换的思维方式的成人礼。

非交换性,并非混乱,而是一种更高级的秩序。它告诉我们,当我们开始处理复杂的、相互关联的系统时,我们必须尊重过程、尊重顺序。矩阵乘法,就是这一深刻哲学的数学体现。它是一座桥梁,连接着代数、几何与计算;它是一把钥匙,开启了描述万物变化与关系的大门。从一个困惑的下午,到对整个科学范式的深刻洞见,这正是数学之旅的魅力所在。